Da mucho que pensar. La nueva IA generativa desarrollada por Microsoft es tan realista y fácil de usar que ni siquiera podrá abrirse al público, al menos en un futuro próximo. El motivo es que los deepfakes que genera son tan creíbles que pueden alterar el resultado de múltiples procesos electorales, entre ellos uno tan trascendental para el devenir de nuestro planeta como las elecciones americanas del próximo 5 de noviembre.

Este nuevo modelo, que ha recibido el nombre de VASA-1, es capaz de alumbrar en tiempo real vídeos extremadamente realistas de personas de carne y hueso a partir de una simple foto, un archivo de audio y un pequeño texto. Aunque nada mejor que el video que ha compartido la compañía para entenderlo más claramente.

El archivo resultante, fácilmente compartible a través de WhatsApp, Instagram o cualquiera de las redes sociales, es un video hiperrealista con sincronización precisa de audio y labios, comportamiento facial realista y movimientos de cabeza naturales, generados en tiempo real.

La nueva IA genera vídeo de alta calidad en tiempo real con una resolución de hasta 512 x 512 píxeles y 40 fps, y una latencia de menos de 170 ms, usando una tarjeta gráfica RTX 4090. Eso sí, de momento (porque llamándose VASA-1 es previsible que pronto le sigan VASA-2 y VASA-3) no clona la voz.

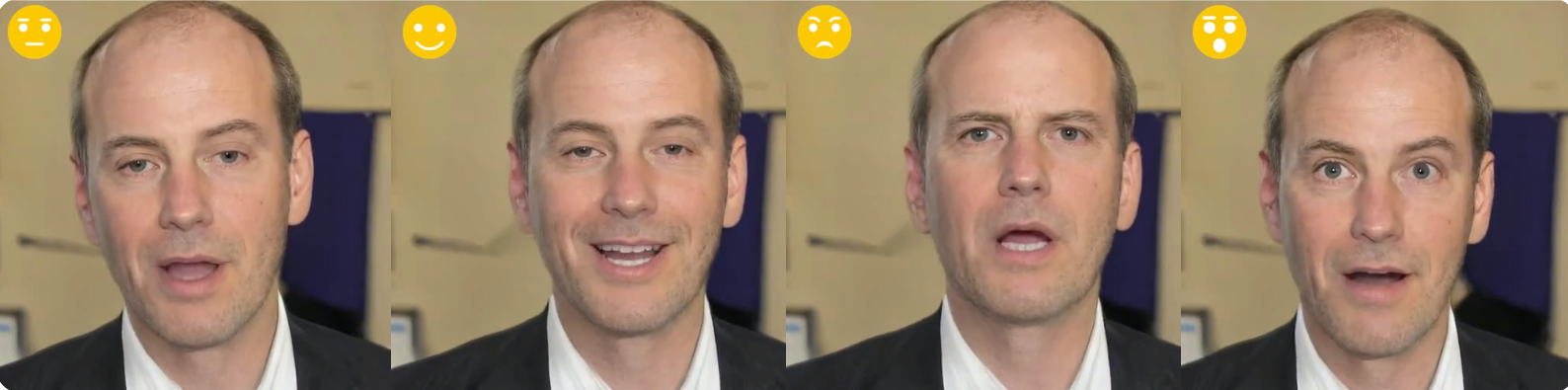

No es por tanto capaz de generar un nuevo audio, sino que utiliza la grabación que le suministramos. Eso sí, la sincronización labial es realmente espectacular. Además, el usuario puede utilizar parámetros de personalización para hacer que el personaje virtual sea más alegre, más serio o más o menos gesticulador. En el mismo discurso, el avatar puede parecer neutral, contento, enfadado o sorprendido.

Aunque Microsoft es una compañía norteamericana, este trabajo ha sido desarrollado por su equipo en Asia, formado por los expertos en IA Sicheng Xu, Guojun Chen, Yu-Xiao Guo, Jiaolong Yang, Chong Li, Zhenyu Zang, Yizhong Zhang, Xin Tong, y Baining Guo.

¿Para qué se va a usar esta IA?

Si Microsoft no quiere abrirla al público para que no se popularice (aún más) el uso de deepfakes, ¿qué cometido se puede dar a una herramienta tan potente? El objetivo inicial, indica la compañía, es emplearla en servicios de atención al cliente. En lugar de mostrar un frío chat de texto o una llamada de voz en la atención al cliente, se puede utilizar un avatar como estos que gesticula y traduce a voz los textos que vaya tecleando un operador.

“Nuestra investigación se centra en generar habilidades visuales afectivas para avatares virtuales de IA, con vistas a aplicaciones positivas. No se pretende crear contenidos que se utilicen para inducir a error o engaño. Sin embargo, al igual que otras técnicas de generación de contenidos relacionadas, todavía podría ser potencialmente mal utilizada para hacerse pasar por humanos. Nos oponemos a cualquier comportamiento para crear contenidos engañosos o perjudiciales de personas reales, y estamos interesados en aplicar nuestra técnica para avanzar en la detección de falsificaciones. En la actualidad, los vídeos generados por este método siguen conteniendo artefactos identificables, y el análisis numérico muestra que aún queda un trecho para lograr la autenticidad de los vídeos reales”, señalan.

No obstante, la compañía de Redmond asegura que los beneficios que puede aportar esta tecnología -como aumentar la equidad educativa, mejorar la accesibilidad de las personas con problemas de comunicación y ofrecer compañía o apoyo terapéutico a quienes lo necesitan- subrayan la valía de VASA-1.

“Nos dedicamos a desarrollar la IA de forma responsable, con el objetivo de mejorar el bienestar humano. En este contexto, no tenemos previsto lanzar ninguna demostración en línea, API, producto, detalles adicionales de implementación ni ninguna oferta relacionada hasta que estemos seguros de que la tecnología se utilizará de forma responsable y de acuerdo con la normativa adecuada”, aseguran.