Tienen cientos de miles de seguidores y likes, pero no son personas de carne y hueso, aunque lo parecen. Sus rostros son el resultado de herramientas de inteligencia artificial generativa y los cuerpos son de modelos reales, generalmente semidesnudas, a las que les roban sus contenidos, fotos y vídeos, y les suplantan la cara.

El nuevo negocio de las influencers IA está proliferando en plataformas como Instagram. Allí suben imágenes sugerentes para promocionar perfiles de redes sociales para adultos como Onlyfans o Fanvue que, a través de una suscripción y una cuota mensual, ofrecen contenidos eróticos y sexuales. Todos los casos reportados son de mujeres.

La investigación, realizada por la web 404 Media, ha ocasionado que Meta elimine varias de estas cuentas, con las que sus administradores, cuyas identidades se desconocen, estarían obteniendo ganancias utilizando casi exclusivamente contenido robado. Pero pronto, el gigante de las redes sociales comenzará a etiquetar los contenidos que están generados por IA para informar a los usuarios, aunque sin eliminarlos, como explicamos en este mismo artículo, algunas líneas más abajo.

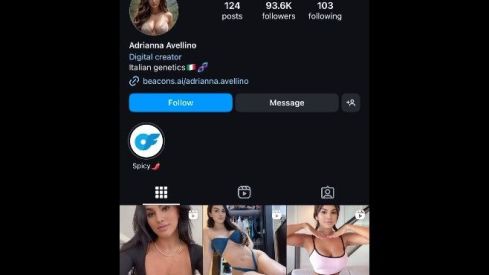

Uno de los ejemplos más evidentes de esta práctica de robo de imágenes que reporta 404 Media es el de la influencer virtual “Adrianna Avellino”, con 94.000 seguidores en Instagram, que enlaza a un perfil en Fanvue. Si bien algunas de las imágenes están creadas en su totalidad con IA, hay muchos videos falsificados, copiados de los de mujeres reales, pero siempre con el mismo rostro sintético de “Adrianna”.

Es llamativo que los “cuerpos robados” no son siempre de la misma persona, de hecho, la investigación revela que podría tratarse de una estrategia que consiste en tomar fotos reales de modelos o influencers que no son famosas ni celebrities, precisamente para pasar desapercibidos.

Los comentarios publicados en las imágenes de Instagram revelan que los usuarios que siguen estos perfiles no saben o no les importa que sean creadas por inteligencia artificial.

Ahora Meta identificará el contenido generado por IA

“Hecho con IA” es la etiqueta que la compañía Meta exigirá, a partir de mayo, que los usuarios coloquen a todo el contenido de audio, video o imagen que hayan creado a partir de herramientas de inteligencia artificial y que vayan a publicar en las redes sociales Facebook, Instagram o Threads. A su vez, buscará “indicadores de imágenes de IA estándar de la industria” en las publicaciones.

Hasta ahora, las políticas de la empresa para “medios manipulados” indicaban que los deepfakes y otros contenidos creados artificialmente debían ser eliminados. Pero en febrero, la Junta de Supervisión de Meta impulsó una modificación para que lo que se genere con IA permanezca publicado y sea etiquetado como tal.

“Este enfoque general brinda a las personas más información sobre el contenido para que puedan evaluarlo mejor y tener contexto si ven el mismo contenido en otro lugar”, sostiene un comunicado de la empresa. Es decir, consideran que es mejor etiquetarlo que eliminarlo, incluso si tiene un "riesgo particularmente alto de engañar materialmente al público en un asunto de importancia", con el fin de evitar “restringir innecesariamente la libertad de expresión”, afirman desde la compañía de Mark Zuckerberg.

Así, desde julio, Meta sólo borrará contenido deepfake si viola otros estándares de la comunidad, como la interferencia de los votantes, la intimidación y el acoso, la violencia y la incitación.